Subiektywna historia rozwoju sił wytwórczych. Warunki dostateczny i konieczne do wytworzenia wyrobu o oczekiwanych parametrach. Próba odpowiedzi na pytanie czym jest BIM.

Chwilową modą, czy naturalną ewolucją sił wytwórczych w budownictwie? A może zmową producentów kreujących rynek oprogramowania?

W barze schroniska w Pieninach wisi wywieszka: „Oferujemy trzy rodzaje usług: tanio, dobrze i szybko. Ale, jeśli wybierzesz tanio i szybko, to nie będzie dobrze. Jeśli szybko i dobrze, to nie tanio. A jeśli tanio i dobrze, to nie szybko.”

Z tej humoreski wypływa mądry wniosek: jakość produktu definiują możliwości wytwórcy.

Jeśli chce się mieć rzeźbę pięknego młodzieńca, to zamawia się ją u Michała Anioła…

…a jeśli szarżę ułanów (bez ułanów), to u Kossaka ojca, a nie wierzy w siłę sprawczą PFU załączonego do SIWZ oferując najniższą zapłatę.

Jeszcze jedna dygresja.

Trójkąt równoboczny by nim był, spełnia jedyny (wystarczający, inaczej: dostateczny) warunek równości wszystkich boków.

W przypadku kwadratu ten warunek nie jest wystarczający – romb nie jest kwadratem, konieczne jest spełnienie kolejnego warunku (koniecznego) np. równości przekątnych.

Najdłużej stosowaną w historii ludzkości bronią i narzędziem był pięściak – mieszczący się w dłoni, jednostronnie zaostrzony kamień krzemienny. Pierwsze pięściaki były prawdopodobnie przypadkowo znajdowane, po pewnym czasie wybierane z rozmysłem, w kolejnej erze już sztucznie obrabiane, a na końcu okresu ewolucji pięściaka, trwającej około miliona lat, pokrywane zdobieniami i przez dodanie drewnianego uchwytu tworzące kamienny toporek. Stworzenie tak wyrafinowanego narzędzia w tamtych czasach wymagało niewątpliwie wiedzy i umiejętności.

Wydaje się, że przez pierwsze tysiące lat rozwoju cywilizacji warunkiem dostatecznym otrzymania dobrego wyrobu była wiedza i doświadczenie wytwórcy. Jeszcze w epoce odkryć geograficznych statki i okręty budowano bez planów konstrukcyjnych na podstawie wiedzy zdobywanej przez doświadczenie i przekazywanej z mistrza na ucznia. Metoda sprawdzała się, była wydajna.

W największej, jak do tej pory, bitwie morskiej pod Lepanto w 1571 r. Imperium Osmańskie wystawiło 300 okrętów, a Liga Święta – 316. Mija ponad trzy i pół wieku, w tym dwie rewolucje przemysłowe i Marynarka Wojenna II RP w przeddzień największej wojny światowej posiada 18 okrętów, a Kriegsmarine 49.

Metoda budowy oparta o wiedzę i doświadczenie zapewniała odpowiednią jakość, a w przypadku statków odpowiednią dzielność morską.

W 1492 r. karaka Santa Maria w towarzystwie dwóch karawel Nina (z hiszpańskiego: dziewczyna) i Pinta (z hiszpańskiego: pomalowany) wyrusza z Kanarów i po pięciu tygodniach dociera do Bahamów po zachodniej stronie Atlantyku.

W 1522 r. karaka Victoria po 38 miesiącach i przepłynięciu 68 tys. km zamyka pętlę wokół ziemi w dodatku płynąc tzw. złą trasą: ze wschodu na zachód pod wiatr i fale. Co prawda, z wysłanych pięciu okrętów powrócił jeden, ale i w XXI w. nie wszystkie wyprawy wokół ziemi kończą się stuprocentowym sukcesem. Jednak każda metoda ma swoje ograniczenia. Na początku XVII w. okręty budowano ciągle bez planów i obliczeń, bazując na wiedzy i doświadczeniu budowniczego.

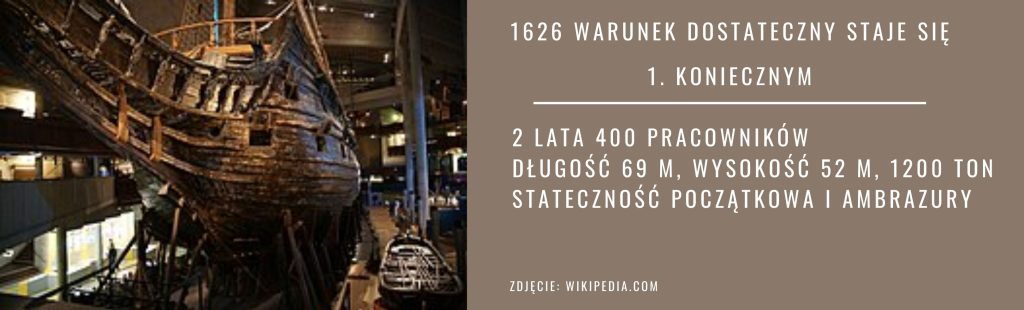

W 1626 r. król Szwecji Gustaw II Adolf zlecił budowę największego we flocie okrętu. Przez dwa lata 400 pracowników stworzyło galeon o wyporności 1.200 ton (karawele Kolumba miały wyporność ok. 50 t), długości 69 m i wysokości 52 m. Na życzenie króla podwyższono burty i najcięższą artylerię umieszczono na górnym pokładzie oraz, w celu zwiększenia prędkości konstrukcyjnej, zmniejszono szerokość kadłuba. Okręt po oddaniu salwy honorowej i uroczystym odbiciu od nabrzeża na oczach króla i gawiedzi przewrócił się i zatonął. Zbyt wysoko umieszczony środek ciężkości względem środka wyporu powodował zbyt małą stateczność początkową, kilka podmuchów wiatru spowodowało wystarczający przechył, by woda, która wlała się do środka przez ambrazury, dopełniła dzieła. Badaniem przyczyn katastrofy zajęła się specjalna komisja, która winą nie obarczyła nikogo. Budowniczy bez nieistniejących jeszcze metod obliczeniowych popartych rysunkami konstrukcyjnymi nie był w stanie przewidzieć i zapobiec wypadkowi. Katastrofa przekreśliła marzenia króla o posiadaniu najpotężniejszego okrętu na Bałtyku i zdegradowała wiedzę i doświadczenie z warunku dostatecznego do jednego z warunków koniecznych wytworzenia produktu o wymaganej jakości.

Przejdźmy do trzeciej ćwierci XX w. Jesteśmy w szczytowej fazie trzeciej rewolucji przemysłowej. Inżynierowie, dzięki rozwojowi metod obliczeniowych i komputerów, potrafią rozwiązać każde bieżące zagadnienie techniczne. Drugi warunek konieczny jest spełniony.

Najsłabszym ogniwem pozostaje graficzne przedstawienie wyników pracy. Kalka i rapidograf są wąskim gardłem produktywności, a stosowanie gumki i żyletki przy wprowadzaniu zmian ogranicza możliwą ilość kroków wstecz.

W 1982 r. startup (według dzisiejszej nomenklatury) AutoDesk przedstawia na targach w Las Vegas program AutoCAD 1.0. Po dziesięciu latach stał się dostawcą nr 1 oprogramowania 2D dostępnego dla zwykłego inżyniera, z przychodem 285 mln $. CAD trafił pod strzechy. Kolejny przełom to wprowadzenie przez Intel 32-bitowych procesorów Pentium, a przez Microsoft 32-bitowego systemu operacyjnego Windows NT.

AutoCAD 2D stał się wydajnym narzędziem i w budownictwie po dziś dzień jest standardem.

Tymczasem w sektorze lotniczym, motoryzacyjnym i budowy maszyn od lat stosowane jest oprogramowanie 3D. W 1995 r. ruszyła produkcja Boeinga 777 stworzonego w trójwymiarowym oprogramowaniu CATIA.

Począwszy od drugiej połowy lat 90 coraz większego znaczenia nabierała globalna sieć www. Producenci oprogramowania zrozumieli znaczenie dostępu do sieci, możliwości B2B, obsługę zdalnych serwerów i wymianę danych 3D CAD przez internet.

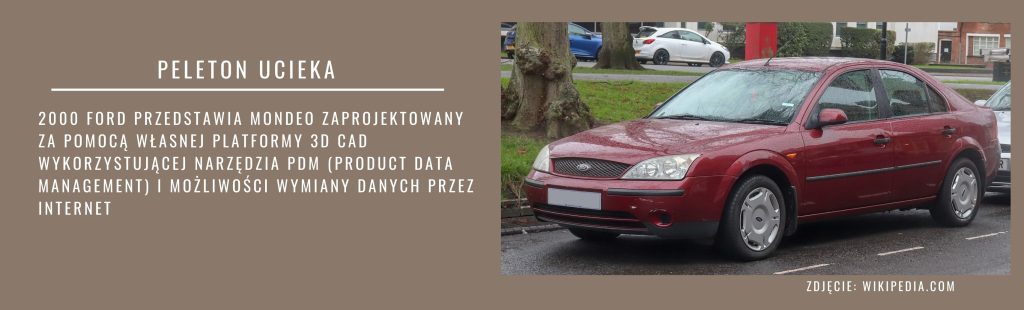

W 2000 r. Ford przedstawił model Mondeo zaprojektowany z wykorzystaniem zintegrowanej własnej platformy 3D CAD, wykorzystującej w pełni narzędzia PDM (Product Data Management) i możliwości wymiany i kontroli danych przez internet. Projekt realizowały równocześnie biura projektowe Forda rozsiane po całym świecie, a ten sam model cyfrowy był wykorzystywany w działach analiz, wytwarzania, marketingu.

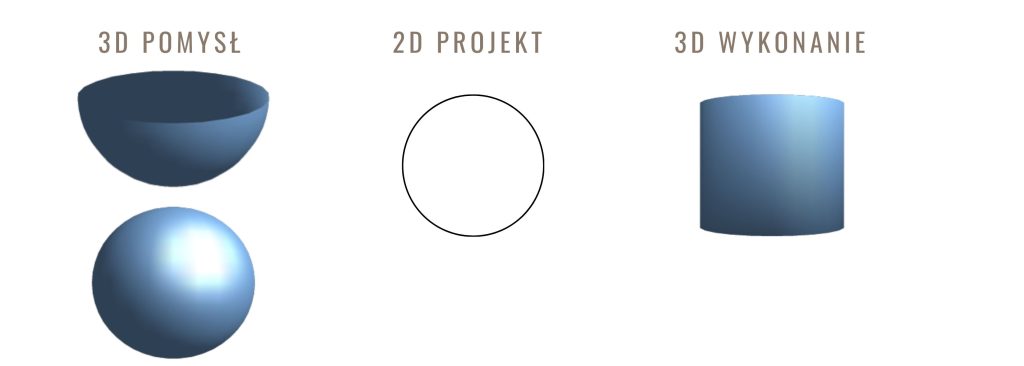

Cofnijmy się w o krok w metodach produkcji i przejdźmy do sektora budownictwa w XXI w. Tu nadal króluje płaskie przedstawianie trójwymiarowych obiektów i szczątkowe stosowanie metod PDM i PLM. W procesie inwestycyjnym konwersja między 3 i 2D występuje dwukrotnie: po raz pierwszy, gdy projektanci przedstawiają przestrzenne obiekty w płaskiej dokumentacji, po raz drugi, gdy wykonawca odtwarza z płaskiego rysunku przestrzenny pomysł projektantów. Nieuchronnie prowadzi to do niejednoznaczności.

Występuje tu pewna paralela do dwóch przeciwstawnych działań matematycznych: różniczkowania i całkowania. Pochodna funkcji ax²+bx+c to 2ax +b +0 w jej wyniku zmniejszył się (o jeden) stopień wielomianu i zginął ostatni element równania. Działanie odwrotne czyli całka funkcji (2ax+b)dx=ax²+bx+c, przywraca pierwotny stopień i współczynniki wielomianu, ale nie można odtworzyć utraconej pierwotnej wartości c. Otrzymujemy rodzinę rozwiązań.

Przechodząc do paraleli w rysunku budowlanym: architekt przestawia na rzucie element będący kulą, jednoznacznie w postaci okręgu. Odtworzenie trzeciego wymiaru przez odbiorcę rysunku nie jest jednoznaczne, możliwe są przynajmniej trzy interpretacje: kula, stożek i walec – wszystkie w rzucie płaskim są okręgami. Dwukrotna transformacja w procesie twórczym 3D-2D-3D – czyli płaskie obrazowanie obiektu trójwymiarowego mające na celu jego trójwymiarowe odtworzenie to proszenie się o nieszczęście.

Początki modelowania obiektowego w budownictwie sięgają 1962 r, jednak wtedy teoria projektowania opartego na obiektach, parametrach i relacyjnej bazie danych nie miała wsparcia sprzętowego. Przez kolejne 20 lat powstało kilka programów, ale dopiero RUNCAPS napisany w Anglii w 1986 r. był pierwszym zastosowanym praktycznie m.in. przy budowie lotniska Heathrow. Już wtedy kształtują się dwa trendy rozwoju oprogramowania: pierwszy to narzędzia do projektowania przez tworzenie modelu i wspomagania budowy, drugi – narzędzia do wykonywania na podstawie modelu symulacji i analiz.

Gabor Bojar, fizyk z Budapesztu, wbrew represjom komunistycznego rządu zakłada prywatną firmę, która w 1984 r. tworzy program RadarCH będący prototypem dzisiejszego ArchiCADa. Do powstania programu konieczne było zastawienie biżuterii żony i przemyt komputera Apple przez żelazną kurtynę. Niestety program wtedy nie był w stanie znaleźć odbiorców z prostej przyczyny – braku powszechnego dostępu do komputerów.

Kolejne wcielenie programu 3D dla budownictwa powstaje w 1988 r. pod nazwą Pro/Engeneer. Jego twórcy: Irwin Jungreis i Leonid Raiz zakładają w Cambridge firmę Charles River Software i w roku 2000 wydają napisany w języku C++ program Revit, co ma oznaczać Rewizja+Szybkość (Revision+Speed).

W 2002 r. Autodesk kupuje program, ciąg dalszy historii wszyscy znamy. Został spełniony trzeci warunek konieczny: zawarcie pełnej i jednoznacznej informacji o projekcie w jego dokumentacji.

Jednak, mimo posiadania wiedzy i doświadczenia, metod i możliwości obliczeniowych oraz jednoznacznego obrazowania projektu, budownictwo pozostaje w ogonie pod względem efektywności w porównaniu z innymi gałęziami przemysłu.

Według badań przeprowadzonych w USA produktywność w gospodarce pozarolniczej w latach 1964-2004 wzrosła ponad 100%, a w budownictwie zmalała o 20%. Jak widać zbiór spełnionych do tej pory warunków koniecznych nie jest kompletny.

Podczas realizacji jednego z pierwszych budynków wysokościowych na Bliskim Wschodzie, prawdopodobnie kategorii ZL1, Jahwe zakłócił proces wymiany informacji pomiędzy stronami procesu inwestycyjnego. Doprowadziło to do opóźnienia prac, katastrofy budowlanej i w ostateczności do odstąpienia od realizacji zamierzenia budowlanego.

Przypadek ten jest opisany w Starym Testamencie w Księdze Rodzaju. Jeśli przyjąć najmłodsze datowanie Księgi Rodzaju to wiedza o tym, że sprawna wymiana informacji między uczestnikami procesu jest kluczowa dla realizacji projektu jest znana ludzkości od ponad 2,5 tys. lat.

Projektowanie obiektu budowlanego (produktu) jest obecnie postrzegane jako proces tworzenia i wymiany informacji, obecnie głównie w postaci dokumentów CAD. Metody Zarządzania Danymi Produktu (Product Data Menagement, PDM) są opracowane i stosowane z powodzeniem od dziesięcioleci w przemyśle maszynowym. Systemy PDM zarządzają danymi pochodzącymi z CAD.

W zakres PDM wchodzi centralna baza plików, standaryzacja ich opisu określająca składnię nazwy, atrybuty, z zapewnieniem całkowitego braku duplikatów, zapewniające automatyczną kontrolę zgodności pliku z regułami, pracę równoczesną, zarządzanie strukturami zespołów, przydział uprawnień oraz reguły podstawowych procesów (workflow) określające sposób wprowadzania zmian czy zarządzania wydaniem.

Systemy PDM współpracują z systemami do planowania zasobów przedsiębiorstwa (ERP), zarządzaniem projektami czy harmonogramowaniem zadań. Z kolei Zarządzanie Cyklem Życia Produktu (Product Lifecycle Management, PLM) jest biznesową strategią zarządzania produktem w całym cyklu jego życia, czyli od fazy koncepcyjnej, przez wytwarzanie i dostawę, aż po serwis i utylizację. Prawdopodobnie brzmi to znajomo osobom osłuchanym z terminologią BIM: Wspólne Środowisko Danych, Modele PIM i AIM, przestrzenie 4, 5 i 6D, arkusz COBie… Obecny BIM jest niczym innym jak próbą implementacji w budownictwie stosowanych z sukcesem w innych gałęziach gospodarki narzędzi PDM i PLM i wydaje się tym ostatnim warunkiem koniecznym. BIM nie jest chwilową modą (ku nieszczęściu zamierzających przeczekać), ale koniecznością, jeśli chcemy budować dobrze, szybko i tanio!

Jacek Szumski